Spis treści

Wyścig o stworzenie w pełni autonomicznego samochodu toczy się na trzech głównych frontach: oprogramowania, legislacji oraz – co kluczowe – sprzętu. Przez lata obserwowaliśmy fascynujący spektakl, w którym Tesla próbowała siłowo przeforsować swoją wizję „Full Self-Driving” (FSD), opierając się na autorskich układach scalonych i pionowej integracji. Elon Musk, niczym samotny wilk, szedł pod prąd, podczas gdy reszta motoryzacyjnego świata coraz chętniej ustawiała się w kolejce po rozwiązania firmy NVIDIA.

Dziś sytuacja staje się napięta. Wiemy już, że długo wyczekiwany czip nowej generacji, Tesla AI5, zaliczył poślizg i nie trafi do seryjnych pojazdów przed 2027 rokiem. To stawia Amerykanów w trudnym położeniu, bo konkurencja nie śpi. Warto więc wziąć pod lupę dwa dominujące obecnie układy, które mają dowieźć nas do ery autonomii: aktualny Hardware 4.0 (AI4) od Tesli oraz potężną platformę NVIDIA Drive Thor. Różnice między nimi to nie tylko cyferki w tabelce – to dwie zupełnie odmienne filozofie budowania samochodu przyszłości.

Starcie Dawida z Goliatem, czyli inżynieria kontra czysta moc

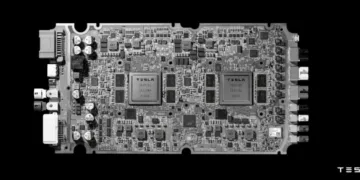

Pierwsza rzecz, która rzuca się w oczy przy analizie specyfikacji, to przepaść technologiczna w samym procesie produkcji. NVIDIA nie bierze jeńców. Ich układ Drive Thor powstaje w oparciu o supernowoczesny proces litograficzny 4N od TSMC (klasa 5 nm). To absolutny szczyt inżynierii półprzewodnikowej, pozwalający upakować na krzemie architekturę Blackwell – dokładnie tę samą, która napędza najpotężniejsze centra danych sztucznej inteligencji na świecie.

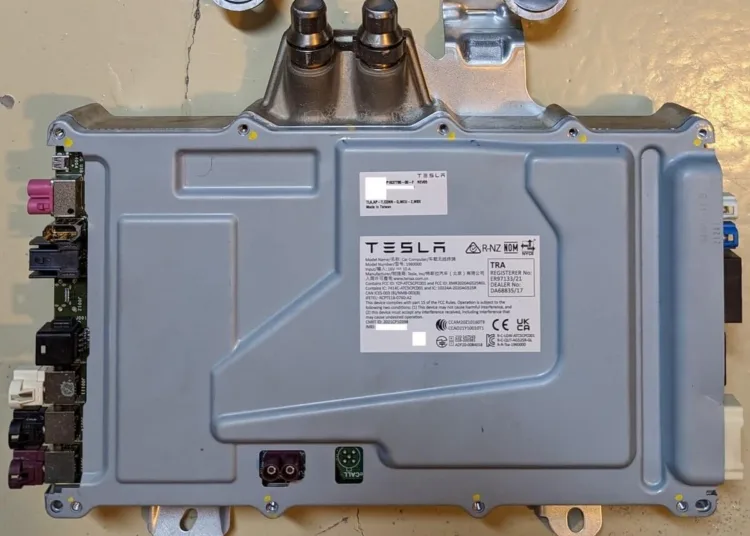

Z drugiej strony mamy Teslę, która wykonała ruch mogący zaskoczyć fanów cyferek. Analizy sprzętowe potwierdzają, że układ AI4 produkowany jest w procesie 7 nm Samsunga. W świecie elektroniki to technologia dojrzała, sprawdzona i – co najważniejsze – tania, ale z pewnością nie jest to „bleeding edge”. Elon Musk postawił na ekonomię i dostępność, podczas gdy NVIDIA celuje w absolutną wydajność, niezależnie od kosztów.

Tabela: Tesla AI4 vs. NVIDIA Drive Thor

Zanim przejdziemy do głębszej analizy, rzućmy okiem na twarde dane. Poniższe zestawienie pokazuje, jak odmienne podejście mają obie firmy do kwestii obliczeń w samochodzie.

| Cecha / Specyfikacja | Tesla AI4 (Hardware 4.0) | NVIDIA Drive Thor (AGX / Jetson) |

| Deweloper / Architekt | Tesla (in-house) | NVIDIA |

| Proces produkcyjny | Samsung 7nm (klasa 7LPP) | TSMC 4N (customowa klasa 5nm) |

| Status rynkowy | W produkcji (od 2023) | W produkcji (od 2025) |

| Architektura CPU | ARM Cortex-A72 (przestarzała) | ARM Neoverse V3AE (serwerowa) |

| Liczba rdzeni CPU | 20 rdzeni (5 klastrów po 4) | 14 rdzeni (konfiguracja Jetson T5000) |

| Wydajność AI (INT8) | ~100–150 TOPS (system dual-SoC) | 1 000 TOPS (na jeden układ) |

| Wydajność AI (FP4) | Brak wsparcia / nieujawnione | 2 000 TFLOPS (na jeden układ) |

| Jednostka NPU | 3× własne rdzenie NPU na SoC | Rdzenie Tensor Blackwell + Transformer Engine |

| Typ pamięci | GDDR6 | LPDDR5X |

| Szyna pamięci | 256-bit | 256-bit |

| Przepustowość pamięci | ~384 GB/s | ~273 GB/s |

| Pobór mocy | Szac. 80–100 W (system) | 40 W – 130 W (konfigurowalne) |

| Wsparcie kamer | 5 MP (własne kamery Tesli) | Skalowalne, 8MP+ i GMSL3 |

| Funkcje specjalne | Redundancja Dual-SoC na jednej płycie | Natywny Transformer Engine, NVLink-C2C |

Magia liczb i pułapka marketingu

Kiedy patrzymy na moc obliczeniową, NVIDIA deklaruje oszałamiające 2000 TFLOPS dla Thora. Brzmi to jak nokaut w pierwszej rundzie, ale jest tu pewien haczyk. Wartość ta dotyczy precyzji FP4 (4-bit floating point) – nowego formatu stworzonego specjalnie dla modeli typu Transformer, wykorzystywanych w generatywnej sztucznej inteligencji.

Dla porównania, Tesla AI4 szacowana jest na około 100–150 TOPS w standardzie INT8, sumując moc obu układów na płytce. Na papierze wygląda to jak rzeź niewiniątek. NVIDIA jest o rzędy wielkości mocniejsza. Jednak inżynierowie Tesli poszli na bardzo specyficzny kompromis, który idealnie pokazuje, co tak naprawdę hamowało ich oprogramowanie.

Wąskie gardło, o którym mało się mówi

Tajemnica tkwi w pamięci. Tesla w przejściu z HW3 na HW4 porzuciła standard LPDDR4 na rzecz GDDR6. To prądożerna pamięć, którą znajdziecie w wydajnych kartach graficznych do gier, a nie w typowych systemach wbudowanych. Dlaczego Musk zdecydował się na taki krok?

Odpowiedzią jest przepustowość. Zastosowanie GDDR6 dało układowi AI4 gigantyczną przepustowość na poziomie około 384 GB/s. Dla porównania, Thor w konfiguracji jednouchwytowej (Jetson) na pamięciach LPDDR5X osiąga „tylko” 273 GB/s.

To jasny sygnał, że strategia „vision-only” (oparta wyłącznie na kamerach, bez LiDAR-u), którą forsuje Tesla, dławiła się brakiem danych. System musiał przetwarzać ogromne ilości surowego wideo z kamer o wysokiej rozdzielczości i po prostu brakowało „rury”, którą te dane mogłyby płynąć do procesora. Co więcej, słowa Elona Muska o tym, że nadchodzący (i opóźniony) chip AI5 będzie miał 5-krotnie większą przepustowość, sugerują, że nawet w AI4 pamięć wciąż może być elementem ograniczającym potencjał sieci neuronowych.

Muzeum w sercu komputera

Gdzie Tesla oszczędzała najbardziej? Spójrzcie na procesor główny (CPU). Układ AI4 wciąż opiera się na rdzeniach ARM Cortex-A72. Dla niezorientowanych: to architektura, która ma już prawie dekadę. W świecie technologii to jak epoka kamienia łupanego. Choć Tesla zwiększyła liczbę rdzeni do 20, nadal mamy do czynienia z przestarzałą technologią.

W tym samym czasie NVIDIA Thor korzysta z rdzeni ARM Neoverse V3AE. To procesory klasy serwerowej, zaprojektowane specjalnie z myślą o nowoczesnych pojazdach definiowanych programowo (Software-Defined Vehicles). Różnica jest kolosalna. Thor ma wystarczający zapas mocy, by obsłużyć nie tylko system autonomicznej jazdy, ale jednocześnie cały system inforozrywki, ekrany pasażerów, a nawet zaawansowanego asystenta AI wewnątrz kabiny. Wszystko to na jednym chipie. Tesla musi dedykować całą moc starych rdzeni na walkę o utrzymanie auta na pasie ruchu.

Problem redundancji i przyszłość autonomii

Jest jeszcze jeden aspekt, o którym mówi się rzadko, a który może być gwoździem do trumny dla marzeń o poziomie 4 i 5 autonomii w obecnych Teslach. Pierwotnie systemy te projektowano z myślą o redundancji – dwa identyczne układy SoC na jednej płycie miały się dublować. Jeśli jeden padnie, drugi przejmuje stery, gwarantując bezpieczeństwo.

Dochodzą nas jednak słuchy, że Tesla obecnie „maxuje” możliwości AI4, wykorzystując moc obu czipów jednocześnie do bieżących obliczeń. Oznacza to utratę marginesu bezpieczeństwa niezbędnego do prawdziwej autonomii bez nadzoru człowieka. Jeśli system potrzebuje 100% zasobów, by w ogóle działać, to co się stanie w przypadku awarii jednego z komponentów?

Dolina śmierci do 2027 roku

Sytuacja Tesli nie wygląda różowo. Mamy rok 2025. Rozwiązania dla starszego Hardware 3 (HW3) wciąż brak, a obiecywany zbawca w postaci AI5 pojawi się dopiero za dwa lata. To dwa lata, w których konkurencja nie będzie stała w miejscu.

Chińscy giganci tacy jak BYD, Zeekr czy Xiaomi, a także amerykański Lucid, masowo adaptują platformę NVIDIA Thor. Miliony samochodów wyposażonych w superkomputery Nvidii wyjadą na drogi, zanim Tesla zdąży wdrożyć swoją nową generację krzemu.

Oczywiście, Tesla prawdopodobnie wygrywa w kategorii ceny. Musk stworzył układ „szyty na miarę”, który był mu potrzebny tu i teraz, eliminując zbędne dla niego funkcje. To inżynieryjny majstersztyk optymalizacji kosztów. Jednak w obliczu opóźnień i rosnącej potęgi rozwiązań „z pudełka” od Nvidii, strategia ta może okazać się ślepą uliczką. Czy Tesla, która sama stworzyła rynek nowoczesnych EV, nie stanie się ofiarą własnego uporu w kwestii sprzętowej izolacji?

A Wy jak oceniacie strategię Elona Muska? Czy wolicie tańsze, optymalizowane układy Tesli, czy jednak czulibyście się bezpieczniej, wiedząc, że Wasze auto napędza serwerowa technologia Nvidii? Dajcie znać w komentarzach!

Dołącz do dyskusji